- #1

Themenstarter/in

Hallo liebe Freunde.

Ich wurde nun schon des Öfteren angefragt, vlt. einen kleinen Einblick hinter meine Produktionskulissen zu gewähren und wie ich meine Hörspielproduktion aufziehe, was und wie ich da eigentlich so mache ?

Okay, dann gerne ein kleiner kurzer Blick hinter den Vorhang.

Mein Workflow ist hier allerdings kein Tutorial und wenngleich ich meine Wege bevorzuge, sind diese auch bitte nicht als allgemeingültig einzig wahres Gelb vom Ei misszuverstehen, denn viele Wege und Workflows führen nach Rom... dieser hier, ist lediglich mein Weg.

Produktive Tage des Wartens

Während ich darauf warte, dass die gecasteten Sprecher und Sprecherinnen nach und nach fleißig ihre Rollen einsprechen, beschäftige ich mich tatkräftig im Vorfeld mit der Musik und Soundeffekte einer Produktion, bzw. setze das um, was ich mir im Skript bereits als Regievorgaben notiert habe, denn zumeist habe ich schon beim Schreiben eines Hörspiels explizite Vorstellungen von Musik und Atmosphäre.

Während der i.d.R. ein bis dreiwöchigen Wartezeit, komponiere ich für die kommende Show also bereits passende Musikstücke wie Leitmotive, Moods und Übergangssequenzen und suche mir auch schon viele Sounds zusammen- oder nehme noch explizit Sounds auf, die ich für das Hörspiel brauchen werde.

In einem Verhältnis von 50:50 verwende ich in meinen Shows eigene, wie auch gekaufte Soundeffekte, da ich gerne die größtmögliche Kontrolle über den von mir verwendeten Content haben möchte und daher nicht auf freie Sounds oder Musik aus dem Netz zurückgreife, weil mir das rechtlich zu unsicher ist.

So erstelle ich vor Produktionsbeginn auch bereits schon erste Demos von Musikstücken oder auch Soundatmosphären wie z.B. eine Action-lastige Weltraumschlacht, welche mancher Sprecher gerne für sich heranzieht, um sich z.B. in Flair und Stimmung des Hörspiels oder Szenerien zu versetzen.

Alles aus einem Guss

Nachdem nun alle Rollen eingesprochen wurden und mich die Aufnahmen erreicht haben, geht es an die technische Sichtung und Aufbereitung der eingereichten Aufnahmen, was mitunter den herausforderndsten Aufwand der Hörspielproduktion ausmacht.

So höre ich mich zunächst durch die Aufnahmen durch (pro Rolle stichprobenartig), um herauszuhören, ob diese technisch verwendbar, frei von z.B. Verzerrungen und ggf. in der Audionachbearbeitung reparabel sind (z.B. Rauschen, Hall entfernen)- oder diese den technischen Anforderungen nicht genügen und neu aufgenommen werden müssen.

Hierbei geht es mir allerdings nicht um die Bewertung der Darbietungen an sich und wie toll ein Take eingesprochen ist, denn der zunächst für sich tollste eingesprochene Take kann mitunter im Dialog mit den separaten Aufnahmen der anderen Sprecher, später etwas unpassend wirken und manchmal ein Retake notwendig wird, damit eine Szene besser miteinander harmoniert.

Das ergibt sich alles wiederum erst später, wenn es an das Eingemachte und in den Dialogschnitt geht, weswegen daher eine Bewertung oder Markierung von „tollen“ Takes im Vorfeld für das spätere Zusammenspiel A), nicht wirklich aussagekräftig ist und B), eine unnötig doppelten Zeitaufwand bedeuten würde, da im Dialogschnitt zwecks Zusammenspiel entsprechende Takes separater Aufnahmen ohnehin gegengehört und dort die miteinander passenden, besten Aufnahmen ausgewählt werden.

Die aufwendigste Aufgabe in der tontechnischen Aufbereitung ist allerdings das Angleichen der sehr verschieden klingenden Sprechersounds untereinander (Spiegel), da die vielen Sprecher und Sprecherinnen auch unterschiedliche Mikrofone und Techniken verwenden und daher vom Sound, bzw. insbesondere vom Frequenzgang, auch unterschiedlich klingen.

Die lohnende Mühe liegt hier darin, einen gleichsam klingenden Sound in der Audionachbearbeitung zu erreichen und somit soundtechnisch alles aus einem Guss klingt, als hätte man hier in meinem Studio am runden Tisch gesessen und alle über das gleiche Mikrofon ihre Parts eingesprochen.

Hierbei geht es nicht nur darum, Nahbesprechungseffekte zu filtern, sondern das gesamte Frequenzspektrum im Auge, bzw. Ohr zu haben und insbesondere die Stärken und Schwächen der vielen unterschiedlich klingenden Mikrofone untereinander abzugleichen und z.B. zu dumpfe, nasale oder zu scharf klingende Aufnahmen entsprechend zu filtern.

Mitunter gibt es hierfür bereits auch schon KI, ich jedoch diesen Prozess nach wie vor händisch und mit den eigenen Ohren praktiziere.

Während der Hörspielproduktion, bzw. im Arrangement und der einhergehenden Abmischung, werden zwar immer noch Details und Kleinigkeiten am Sprechersound angepasst, aber der Grundsound untereinander steht bereits und soll meine Vorgehensweise daher auch vor etwaig modifizierenden Eingriffen bewahren, die den Sound des Hörspiels während des Produktionsprozess, unvorhergesehen und massiv nachteilig beeinflussen.

Steht der aufbereitete Grundsound der Sprecher und Sprecherinnen, geht es somit endlich auch in die eigentliche Hörspielproduktion mit Dialogschnitt, Sound und Musikarrangement.

Multitasking-Arrangements

Es ist mir am liebsten, wenn ich eine Produktion chronologisch von Kapitel 1 bis zum letzten Kapitel durcharbeiten kann.

Diese Entwicklung, gleichwohl man seine selbst geschriebene Geschichte kennt, auch eine gewisse Eigendynamik und Spannung mit sich bringt und fern von Skript und Regie, hin und wieder auch auf andere Ideen kommt, die so nicht im Skript standen.

Das Hörspiel entwickelt mit der Zeit gewissermaßen auch ein kleines Eigenleben.

Andererseits bevorzuge ich auch eine schnelle Produktion sowie Fertigstellung und daher auch- wenn es schnell gehen muss, jene Kapitel fertig stelle, in denen die mir schon zur Verfügung stehenden Rollen zusammen wirken können, während ich noch hier und dort auf andere einzusprechende Takes der Sprecher für die anderen Kapitel warte.

Allerdings vermeide ich grundsätzlich, mit dem final abschließenden Kapitel zu beginnen, da ich für mich auch die sich im Hörspiel entwickelnde Atmosphäre durch Sound-FX, Atmo und Musik etc. brauche, die mich durch die Show trägt.

So kann es mir mitunter passieren, dass ein insbesondere fertig gestelltes Finale nicht mit dem Rest des Hörspiels harmoniert und neu arrangiert werden müsse, was wiederum Zeit kostet.

In meinem Workflow versuche ich so schnell wie möglich einen annähernd finalen Soundmix zu erreichen, weswegen Dialogschnitt, SFX und Musik Hand in Hand gehend, Kapitel für Kapitel simultan arrangiert werden.

Es beschleunigt meinen eigenen Workflow ungemein, andererseits macht es mir einfach mehr Spaß und motiviert zusätzlich, noch während des Schaffensprozesses das Arrangement im bereits (annähernd) finalen Zustand zu hören.

Natürlich ist dies nur eine Methode von vielen, doch hat sich für mich dieser Weg im Gegensatz dazu, z.B. erst den Dialogschnitt fertig zu stellen, dann die Sounds und zuletzt die Musik einzubinden, als kreativer und effizient zu fertigen Ergebnissen kommend, bewährt.

Für mein Dafürhalten, lebt ein Hörspiel nicht vom Dialog allein und so sind es auch Sounds und Musik, die im Zusammenspiel einen gewichtigen Moment der Handlung übernehmen können und ein bereits fertig geschnittener Dialog wiederum auseinandergebaut und neu zusammengestellt werden müsse, weil ggf. Tempo, Dramaturgie, Timing etc. nicht stimmig sind oder auch der nötige Platz für ein markantes Soundevent oder die Musik fehlt.

Für mich haben Dialog, Sound und Musik eine zusammengehörige Gewichtung und es sich für meine bescheidene Art der Hörspielproduktion besser eignet, diese Dinge Hand in Hand gehend, gleich synchron zueinander arrangieren.

Kontrolle im Dialogschnitt

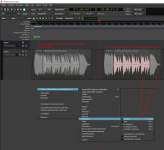

Jeder Sprecher bekommt von mir wenigstens eine zweite Spur im Arrangement (zumeist aber 3-4 Spuren), um auf diesen Spuren z.B. komplexe Automationen und Eingriffe auslagern zu können, damit mir die Hauptspur eines Sprechers, auf denen üblicherweise die im Hörspiel durchgehenden Basiseffekte und z.B festen Positionen im Raum drauf liegen, nicht zerstört werden.

Zudem, weil auch je nach Projektgröße 30-50 Spuren für die Darsteller zusammenkommen (Soundstages und Musik nicht mitgerechnet), dies der besseren Übersicht und schnellen Zugriff bei sehr komplexen Eingriffen ermöglicht.

Alle Automationsdaten auf z.B. nur der Hauptspur zu haben, wäre zu viel an Information und man sprichwörtlich den Wald vor lauter Bäumen nicht mehr sähe.

Ich handhabe es in etwa ähnlich wie bei einer Musikproduktion und z.B. der Abnahme eines Schlagzeugs, wo jedes Instrument von der Kick über die Snare bis hin zu den Toms und Becken natürlich auch ihre eigenen Spuren bekommen, inklusive der zugehörig eigenen Spuren für z.B. die Overheads usw... summa summarum, würde das Schlagzeug also bei mir auch nicht auf nur einer einzigen Spur liegen und so in etwa ähnlich, verfahre ich im Dialogschnitt mit den Sprechern, was mir größtmögliche Freiheit und schnellen Zugriff bei etwaig komplexen Eingriffen gewährt.

So, ich will euch aber nun nicht zu sehr mit Tech-Sprech langweilen und hoffe, ihr habt einen entsprechend kleinen Blick in meine Hexenküche werfen können.

Euch weiterhin frohes Schaffen gewünscht.

Wir sehen/hören uns in den Projekten.

Markus

Ich wurde nun schon des Öfteren angefragt, vlt. einen kleinen Einblick hinter meine Produktionskulissen zu gewähren und wie ich meine Hörspielproduktion aufziehe, was und wie ich da eigentlich so mache ?

Okay, dann gerne ein kleiner kurzer Blick hinter den Vorhang.

Mein Workflow ist hier allerdings kein Tutorial und wenngleich ich meine Wege bevorzuge, sind diese auch bitte nicht als allgemeingültig einzig wahres Gelb vom Ei misszuverstehen, denn viele Wege und Workflows führen nach Rom... dieser hier, ist lediglich mein Weg.

Produktive Tage des Wartens

Während ich darauf warte, dass die gecasteten Sprecher und Sprecherinnen nach und nach fleißig ihre Rollen einsprechen, beschäftige ich mich tatkräftig im Vorfeld mit der Musik und Soundeffekte einer Produktion, bzw. setze das um, was ich mir im Skript bereits als Regievorgaben notiert habe, denn zumeist habe ich schon beim Schreiben eines Hörspiels explizite Vorstellungen von Musik und Atmosphäre.

Während der i.d.R. ein bis dreiwöchigen Wartezeit, komponiere ich für die kommende Show also bereits passende Musikstücke wie Leitmotive, Moods und Übergangssequenzen und suche mir auch schon viele Sounds zusammen- oder nehme noch explizit Sounds auf, die ich für das Hörspiel brauchen werde.

In einem Verhältnis von 50:50 verwende ich in meinen Shows eigene, wie auch gekaufte Soundeffekte, da ich gerne die größtmögliche Kontrolle über den von mir verwendeten Content haben möchte und daher nicht auf freie Sounds oder Musik aus dem Netz zurückgreife, weil mir das rechtlich zu unsicher ist.

So erstelle ich vor Produktionsbeginn auch bereits schon erste Demos von Musikstücken oder auch Soundatmosphären wie z.B. eine Action-lastige Weltraumschlacht, welche mancher Sprecher gerne für sich heranzieht, um sich z.B. in Flair und Stimmung des Hörspiels oder Szenerien zu versetzen.

Alles aus einem Guss

Nachdem nun alle Rollen eingesprochen wurden und mich die Aufnahmen erreicht haben, geht es an die technische Sichtung und Aufbereitung der eingereichten Aufnahmen, was mitunter den herausforderndsten Aufwand der Hörspielproduktion ausmacht.

So höre ich mich zunächst durch die Aufnahmen durch (pro Rolle stichprobenartig), um herauszuhören, ob diese technisch verwendbar, frei von z.B. Verzerrungen und ggf. in der Audionachbearbeitung reparabel sind (z.B. Rauschen, Hall entfernen)- oder diese den technischen Anforderungen nicht genügen und neu aufgenommen werden müssen.

Hierbei geht es mir allerdings nicht um die Bewertung der Darbietungen an sich und wie toll ein Take eingesprochen ist, denn der zunächst für sich tollste eingesprochene Take kann mitunter im Dialog mit den separaten Aufnahmen der anderen Sprecher, später etwas unpassend wirken und manchmal ein Retake notwendig wird, damit eine Szene besser miteinander harmoniert.

Das ergibt sich alles wiederum erst später, wenn es an das Eingemachte und in den Dialogschnitt geht, weswegen daher eine Bewertung oder Markierung von „tollen“ Takes im Vorfeld für das spätere Zusammenspiel A), nicht wirklich aussagekräftig ist und B), eine unnötig doppelten Zeitaufwand bedeuten würde, da im Dialogschnitt zwecks Zusammenspiel entsprechende Takes separater Aufnahmen ohnehin gegengehört und dort die miteinander passenden, besten Aufnahmen ausgewählt werden.

Die aufwendigste Aufgabe in der tontechnischen Aufbereitung ist allerdings das Angleichen der sehr verschieden klingenden Sprechersounds untereinander (Spiegel), da die vielen Sprecher und Sprecherinnen auch unterschiedliche Mikrofone und Techniken verwenden und daher vom Sound, bzw. insbesondere vom Frequenzgang, auch unterschiedlich klingen.

Die lohnende Mühe liegt hier darin, einen gleichsam klingenden Sound in der Audionachbearbeitung zu erreichen und somit soundtechnisch alles aus einem Guss klingt, als hätte man hier in meinem Studio am runden Tisch gesessen und alle über das gleiche Mikrofon ihre Parts eingesprochen.

Hierbei geht es nicht nur darum, Nahbesprechungseffekte zu filtern, sondern das gesamte Frequenzspektrum im Auge, bzw. Ohr zu haben und insbesondere die Stärken und Schwächen der vielen unterschiedlich klingenden Mikrofone untereinander abzugleichen und z.B. zu dumpfe, nasale oder zu scharf klingende Aufnahmen entsprechend zu filtern.

Mitunter gibt es hierfür bereits auch schon KI, ich jedoch diesen Prozess nach wie vor händisch und mit den eigenen Ohren praktiziere.

Während der Hörspielproduktion, bzw. im Arrangement und der einhergehenden Abmischung, werden zwar immer noch Details und Kleinigkeiten am Sprechersound angepasst, aber der Grundsound untereinander steht bereits und soll meine Vorgehensweise daher auch vor etwaig modifizierenden Eingriffen bewahren, die den Sound des Hörspiels während des Produktionsprozess, unvorhergesehen und massiv nachteilig beeinflussen.

Steht der aufbereitete Grundsound der Sprecher und Sprecherinnen, geht es somit endlich auch in die eigentliche Hörspielproduktion mit Dialogschnitt, Sound und Musikarrangement.

Multitasking-Arrangements

Es ist mir am liebsten, wenn ich eine Produktion chronologisch von Kapitel 1 bis zum letzten Kapitel durcharbeiten kann.

Diese Entwicklung, gleichwohl man seine selbst geschriebene Geschichte kennt, auch eine gewisse Eigendynamik und Spannung mit sich bringt und fern von Skript und Regie, hin und wieder auch auf andere Ideen kommt, die so nicht im Skript standen.

Das Hörspiel entwickelt mit der Zeit gewissermaßen auch ein kleines Eigenleben.

Andererseits bevorzuge ich auch eine schnelle Produktion sowie Fertigstellung und daher auch- wenn es schnell gehen muss, jene Kapitel fertig stelle, in denen die mir schon zur Verfügung stehenden Rollen zusammen wirken können, während ich noch hier und dort auf andere einzusprechende Takes der Sprecher für die anderen Kapitel warte.

Allerdings vermeide ich grundsätzlich, mit dem final abschließenden Kapitel zu beginnen, da ich für mich auch die sich im Hörspiel entwickelnde Atmosphäre durch Sound-FX, Atmo und Musik etc. brauche, die mich durch die Show trägt.

So kann es mir mitunter passieren, dass ein insbesondere fertig gestelltes Finale nicht mit dem Rest des Hörspiels harmoniert und neu arrangiert werden müsse, was wiederum Zeit kostet.

In meinem Workflow versuche ich so schnell wie möglich einen annähernd finalen Soundmix zu erreichen, weswegen Dialogschnitt, SFX und Musik Hand in Hand gehend, Kapitel für Kapitel simultan arrangiert werden.

Es beschleunigt meinen eigenen Workflow ungemein, andererseits macht es mir einfach mehr Spaß und motiviert zusätzlich, noch während des Schaffensprozesses das Arrangement im bereits (annähernd) finalen Zustand zu hören.

Natürlich ist dies nur eine Methode von vielen, doch hat sich für mich dieser Weg im Gegensatz dazu, z.B. erst den Dialogschnitt fertig zu stellen, dann die Sounds und zuletzt die Musik einzubinden, als kreativer und effizient zu fertigen Ergebnissen kommend, bewährt.

Für mein Dafürhalten, lebt ein Hörspiel nicht vom Dialog allein und so sind es auch Sounds und Musik, die im Zusammenspiel einen gewichtigen Moment der Handlung übernehmen können und ein bereits fertig geschnittener Dialog wiederum auseinandergebaut und neu zusammengestellt werden müsse, weil ggf. Tempo, Dramaturgie, Timing etc. nicht stimmig sind oder auch der nötige Platz für ein markantes Soundevent oder die Musik fehlt.

Für mich haben Dialog, Sound und Musik eine zusammengehörige Gewichtung und es sich für meine bescheidene Art der Hörspielproduktion besser eignet, diese Dinge Hand in Hand gehend, gleich synchron zueinander arrangieren.

Kontrolle im Dialogschnitt

Jeder Sprecher bekommt von mir wenigstens eine zweite Spur im Arrangement (zumeist aber 3-4 Spuren), um auf diesen Spuren z.B. komplexe Automationen und Eingriffe auslagern zu können, damit mir die Hauptspur eines Sprechers, auf denen üblicherweise die im Hörspiel durchgehenden Basiseffekte und z.B festen Positionen im Raum drauf liegen, nicht zerstört werden.

Zudem, weil auch je nach Projektgröße 30-50 Spuren für die Darsteller zusammenkommen (Soundstages und Musik nicht mitgerechnet), dies der besseren Übersicht und schnellen Zugriff bei sehr komplexen Eingriffen ermöglicht.

Alle Automationsdaten auf z.B. nur der Hauptspur zu haben, wäre zu viel an Information und man sprichwörtlich den Wald vor lauter Bäumen nicht mehr sähe.

Ich handhabe es in etwa ähnlich wie bei einer Musikproduktion und z.B. der Abnahme eines Schlagzeugs, wo jedes Instrument von der Kick über die Snare bis hin zu den Toms und Becken natürlich auch ihre eigenen Spuren bekommen, inklusive der zugehörig eigenen Spuren für z.B. die Overheads usw... summa summarum, würde das Schlagzeug also bei mir auch nicht auf nur einer einzigen Spur liegen und so in etwa ähnlich, verfahre ich im Dialogschnitt mit den Sprechern, was mir größtmögliche Freiheit und schnellen Zugriff bei etwaig komplexen Eingriffen gewährt.

So, ich will euch aber nun nicht zu sehr mit Tech-Sprech langweilen und hoffe, ihr habt einen entsprechend kleinen Blick in meine Hexenküche werfen können.

Euch weiterhin frohes Schaffen gewünscht.

Wir sehen/hören uns in den Projekten.

Markus

Zuletzt bearbeitet: